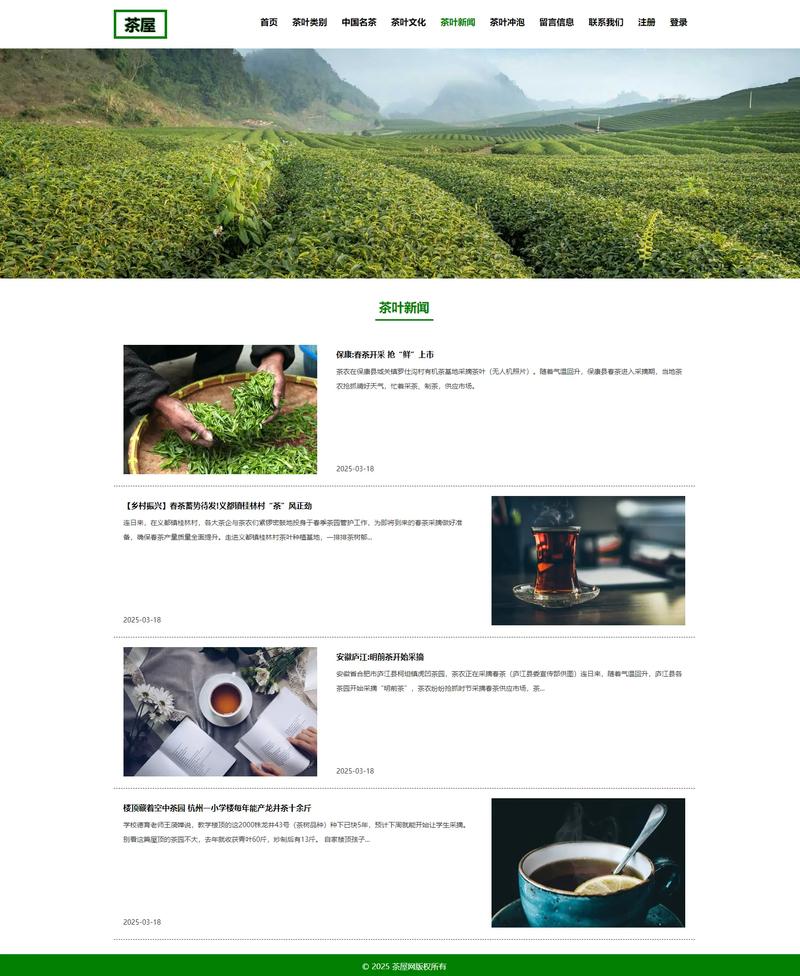

浏览器直接保存(最简单,适合个人查看)

这是最快的方法,但无法下载到网站的所有文件(如图片、CSS、JS等),只能保存你当前看到的主页HTML文件。

(图片来源网络,侵删)

步骤:

- 打开目标网站:在浏览器(如 Chrome, Firefox, Edge, Safari)中输入网址,打开你想要下载的页面。

- 打开开发者工具:

- 快捷键:按

F12键。 - 菜单:右键点击页面空白处,选择“检查”或“检查元素”。

- 快捷键:按

- 切换到“网络”标签页:在开发者工具窗口中,点击顶部的“网络”或“Network

- 清空并刷新:点击网络标签页中的“清空”按钮(一个圆形的箭头图标),然后按

F5或点击刷新按钮刷新整个页面,这一步是为了只捕获当前页面加载的所有资源。- 复制为 cURL:

- 在网络列表中,找到名为

document或index.html的请求(通常是列表中的第一个),右键点击它。 - 在弹出的菜单中,选择“复制” -> “复制为 cURL (bash)”。

- 使用命令行下载:

- Windows: 打开命令提示符 或 PowerShell,右键点击窗口选择“粘贴”,然后按回车。

- macOS / Linux: 打开终端,右键点击窗口选择“粘贴”,然后按回车。

- 清空并刷新:点击网络标签页中的“清空”按钮(一个圆形的箭头图标),然后按

这个命令会下载主页的HTML文件以及它引用的所有关键资源(图片、CSS、JS等),并将它们保存在一个与网站域名同名的文件夹里。

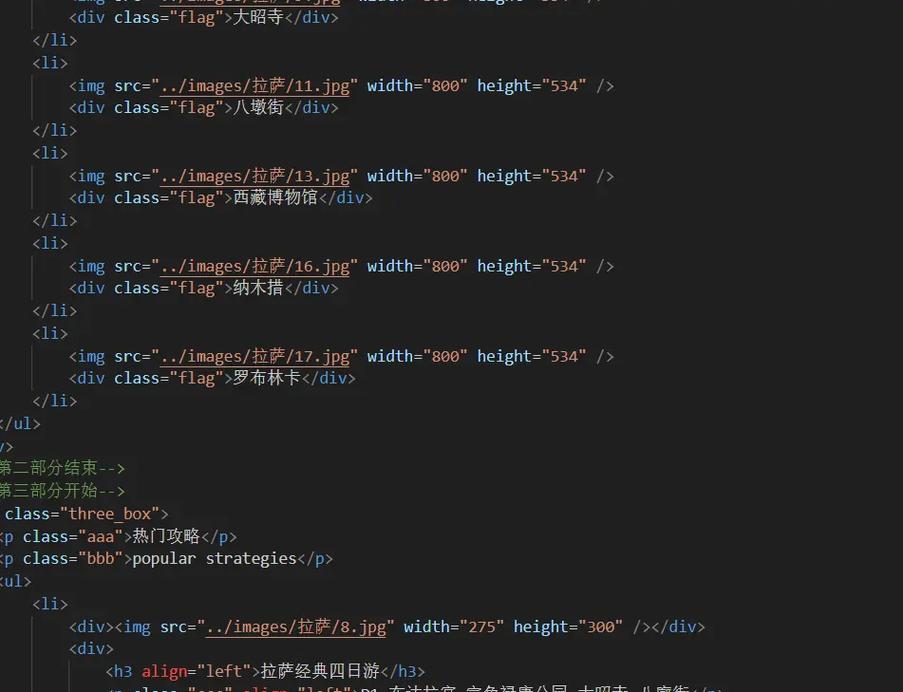

使用命令行工具(最强大、最推荐)

这是最专业、最完整的方法,可以下载整个网站的所有可见文件,并保持目录结构,我们推荐使用 wget 或 httrack。

A. 使用 wget (Linux, macOS, Windows WSL 或 Git Bash)

wget 是一个非常强大的命令行下载工具。

(图片来源网络,侵删)

基本命令:

wget --mirror --convert-links --adjust-extension --page-requisites --no-parent http://example.com

命令解释:

--mirror: 镜像模式,相当于-r -N -l inf --no-remove-listing,会递归下载整个网站。--convert-links: 下载完成后,将HTML/CSS文件中的链接转换为本地链接,方便离线浏览。--adjust-extension: 根据MIME类型为文件添加正确的扩展名(将没有.html后缀的文件加上)。--page-requisites: 下载所有显示该网页所需的文件,如图片、CSS、JS等。--no-parent: 不跟随父级目录的链接,防止下载到网站根目录之外的文件。

如何安装 wget:

- Windows: 下载 Git for Windows 并安装,它会自带 Git Bash,其中包含

wget。 - macOS: 如果使用 Homebrew,可以通过

brew install wget安装。 - Linux (Ubuntu/Debian):

sudo apt-get install wget

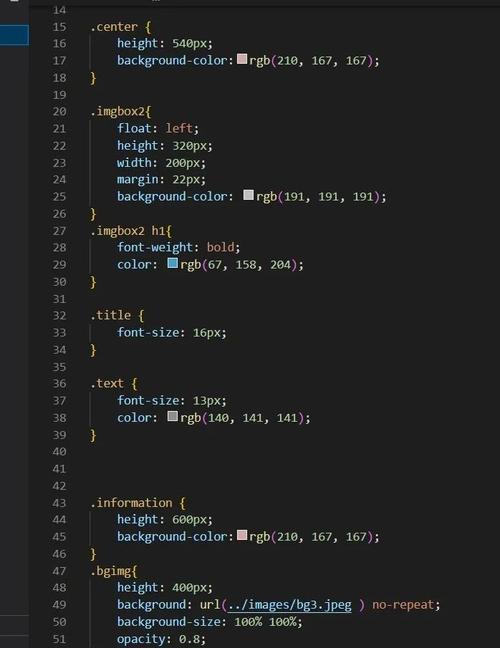

B. 使用 HTTrack (图形界面工具,非常适合新手)

HTTrack 是一个专门用于网站镜像的工具,它有图形界面,操作非常直观。

(图片来源网络,侵删)

步骤:

- 下载并安装 HTTrack: 访问 HTTrack 官网 下载并安装。

- 创建新项目: 打开 HTTrack,点击 "Next"。

- 输入项目名称和基础路径: 给你的项目起个名字,并选择一个保存路径。

- 输入要下载的网址: 在 "Web project" 栏中输入你要下载的网站地址,

https://www.example.com。 - 设置选项: 点击 "Enter" 或 "Next" 进入设置页面。

- 在 "Action" 中,选择 "Mirror Web Site"。

- 在 "Proxy" 部分,确保没有勾选 "Use a proxy"。

- 在 "Mirror" 选项中,你可以选择下载深度(通常选择 "Entire site, all levels")。

- 开始下载: 点击 "Finish",然后点击 "Start" 开始下载,它会自动处理所有链接,并创建一个与网站结构完全相同的本地文件夹。

使用在线工具(最方便,但有隐私风险)

有很多网站提供“在线下载网站源码”的服务,你只需要输入网址,它们就会打包好整个网站供你下载。

优点:

- 无需安装任何软件,操作简单。

- 适合快速下载一些不涉及个人隐私的网站。

缺点:

- 隐私风险:你输入的网址会被服务提供商看到。

- 文件大小限制:通常对下载的网站大小有限制。

- 下载不稳定:速度可能很慢,或者直接失败。

- 可能被篡改:下载的文件包中可能被植入广告或恶意代码。

如何使用(以 download-website.com 为例):

- 打开类似

download-website.com或websitedownloader.io的网站。 - 在输入框中粘贴目标网址。

- 选择你想要的选项(如是否包含CSS、JS、图片等)。

- 点击 "Download" 按钮。

- 等待处理完成后,它会提供一个下载链接,让你下载一个

.zip压缩包。

总结与建议

| 方法 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 浏览器保存 | 极其简单,无需工具 | 只能保存主页,不完整,无法离线浏览 | 个人快速查看某页面的HTML代码 |

命令行 wget |

功能最强大,完全可控,下载最完整,适合自动化 | 需要基本命令行知识 | 开发者、技术爱好者,需要完整镜像网站 |

图形界面 HTTrack |

操作直观,功能强大,适合新手 | 需要安装软件 | 新手用户,想完整下载一个网站离线观看 |

| 在线工具 | 最方便,无需安装 | 有隐私风险,有大小限制,可能不稳定 | 快速下载小型公开网站,不介意隐私风险 |

我的建议:

- 如果你只是想看看某页面的代码:用方法一。

- 如果你想完整下载一个网站用于离线学习或分析:强烈推荐使用方法二中的

wget或HTTrack。wget更专业,HTTrack对新手更友好。 - 如果你只是临时用一下,且网站不大:可以尝试方法三,但要记住它的潜在风险。