R 语言与网站分析:从数据到洞察的完整指南

网站分析的核心是理解用户行为,优化产品体验,并最终提升业务指标(如转化率、用户留存、收入等),R 语言凭借其强大的数据处理、统计建模和可视化能力,在这一领域大放异彩。

(图片来源网络,侵删)

核心优势

- 强大的数据处理能力:

dplyr和tidyr包可以轻松处理从 Google Analytics、服务器日志等来源获取的、结构可能非常复杂的数据。 - 顶尖的统计分析:

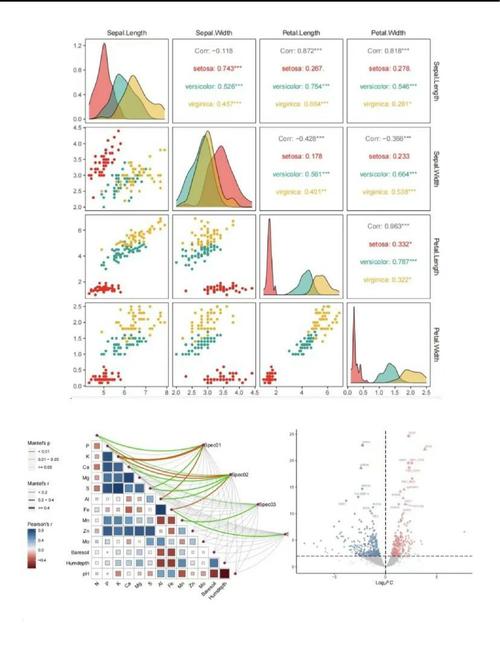

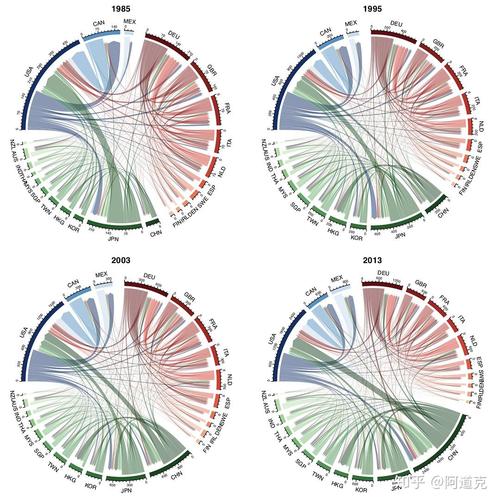

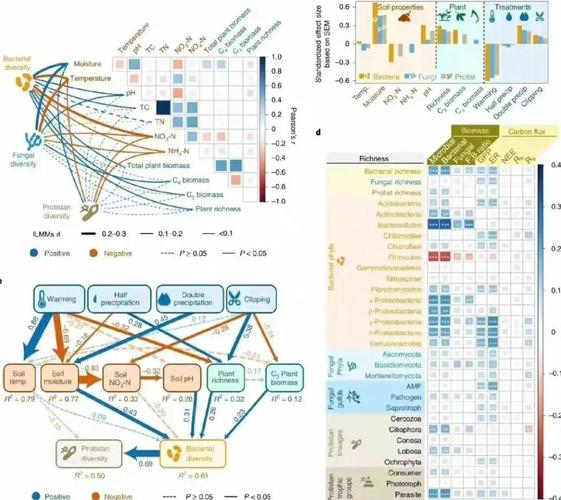

stats包(内置)和lme4,survival等包可以进行高级统计建模,如回归分析、生存分析(用于用户留存)、时间序列分析(用于流量预测)等。 - 精美的数据可视化:

ggplot2是数据可视化的黄金标准,能让你创建出高度定制化、信息丰富的图表,远超大多数分析工具的默认报表。 - 可重复性:整个分析流程可以写成 R Markdown 文档,将代码、结果和叙述性文字完美结合,便于报告和复现。

- 成本效益:R 是开源的,无需为昂贵的商业分析软件付费。

第一部分:数据从哪里来?

要进行网站分析,首先需要获取数据,主要来源包括:

- Google Analytics (GA) API:最常见的数据来源,你可以通过 R 连接到 GA,提取用户行为、流量来源、转化等数据。

- 服务器日志文件:包含了用户与网站的每一次交互记录,数据粒度最细,但解析起来也最复杂。

- 其他分析平台:如 Adobe Analytics, Piwik 等,它们通常也提供 API 接口。

- A/B 测试数据:可以直接从 A/B 测试平台(如 Google Optimize, Optimizely)导出,或在 R 中进行模拟分析。

第二部分:核心 R 包与工具

你需要熟悉以下几个核心 R 包:

| 包名 | 主要功能 | 网站分析应用场景 |

|---|---|---|

tidyverse |

数据科学的“瑞士军刀”,包含 dplyr, ggplot2, tidyr 等。 |

几乎所有环节:数据清洗、转换、聚合、可视化。 |

googleAnalyticsR |

连接 Google Analytics API 的官方/推荐包。 | 从 GA 提取数据,是整个流程的起点。 |

lubridate |

专门用于处理日期和时间数据。 | 处理时间戳,进行时间序列分析,计算用户会话时长。 |

survival |

生存分析。 | 核心应用:分析用户留存/流失率,计算用户生命周期。 |

Cohort |

专门用于队列分析。 | 分析不同用户群(如按注册月份)的长期留存行为。 |

bayesAB |

A/B 测试的贝叶斯方法。 | 进行更直观的 A/B 测试,理解不同版本的概率分布。 |

RMarkdown |

生成动态报告。 | 将你的分析过程和结果整合成精美的报告或仪表板。 |

第三部分:一个完整的分析工作流

我们将以 从 Google Analytics 提取数据,并进行用户留存分析 为例,展示一个完整的流程。

步骤 1:准备工作

- 安装 R 和 RStudio:这是你的开发环境。

- 安装必要的 R 包:

install.packages("tidyverse") install.packages("googleAnalyticsR") install.packages("lubridate") install.packages("survival") install.packages("Cohort") - 获取 Google Analytics API 凭据:

- 在 Google Cloud Console 中创建一个项目。

- 启用 "Google Analytics Data API v1"。

- 创建 OAuth 2.0 客户 ID,类型选择“桌面应用”。

- 下载

client_secret.json文件,并放在你的 R 工作目录中。

步骤 2:连接 Google Analytics 并提取数据

# 加载包

library(googleAnalyticsR)

library(tidyverse)

library(lubridate)

# 认证 (首次运行会弹出浏览器窗口让你登录)

ga_auth()

# 获取你账户下的所有 View ID

ga_account_list()

# 假设你的 View ID 是 123456789

view_id <- 123456789

# 定义查询参数

# 提取过去 90 天的新用户数据,按天分组

# metrics: 新用户数、会话数

# dimensions: 日期

ga_data <- google_analytics(

view_id,

date_range = c(today() - 90, today()),

metrics = c("users", "sessions"),

dimensions = c("date"),

anti_sample = TRUE # 尽量获取未采样的数据

)

# 查看数据

head(ga_data)

步骤 3:数据清洗与转换

我们从 GA 获取的数据通常是整洁的,但为了分析,我们可能需要做一些调整。

(图片来源网络,侵删)

# 将 date 列从字符转换为日期类型

ga_data <- ga_data %>%

mutate(date = ymd(date))

# 创建一个包含所有日期的完整数据框,避免某些天没有数据导致的分析偏差

all_dates <- tibble(date = seq(min(ga_data$date), max(ga_data$date), by = "day"))

# 合并数据,并用 0 填充没有用户的天

ga_data_complete <- all_dates %>%

left_join(ga_data, by = "date") %>%

mutate(users = replace_na(users, 0),

sessions = replace_na(sessions, 0))

# 查看处理后的数据

head(ga_data_complete)

步骤 4:核心分析 - 用户留存分析

留存分析是衡量网站健康度的关键指标,我们将使用 survival 包来分析用户的“生存”(即不流失)概率。

假设:我们想分析“首次访问日期”为 2025-10-01 的这群用户,在之后的日子里有多少人还会回来。

library(survival)

# 1. 创建一个“首次访问”的队列

# 我们假设 ga_data 中每天都是新用户的首次访问

# 在实际应用中,你需要一个包含用户ID和首次访问日期的表

# 这里我们简化模型,用日期代表队列

# 2. 准备生存分析数据

# 我们需要一个数据框,包含:

# - time: 用户“存活”的时间(天)

# - status: 是否“死亡”(即流失,1=流失,0=仍在“存活”/活跃)

# - cohort: 队列(这里是首次访问的日期)

# 模拟一个简单的留存数据

# 假设队列日期是 2025-10-01

cohort_date <- ymd("2025-10-01")

# 从完整数据中提取该队列之后的数据

cohort_data <- ga_data_complete %>%

filter(date >= cohort_date)

# 为每一天计算“存活”用户数

# 这是一个简化的例子,真实数据需要追踪每个用户

# 这里我们用会话数来近似表示活跃用户

survival_df <- cohort_data %>%

mutate(time = as.numeric(date - cohort_date) + 1, # 第1天, 第2天...

status = ifelse(time == 1, 0, 1)) # 简化处理:第一天都算活跃,之后都算流失

# 3. 进行生存分析

survival_model <- survfit(Surv(time, status) ~ 1, data = survival_df)

# 4. 可视化生存曲线

library(survminer)

ggsurvplot(survival_model,

data = survival_df,

pval = TRUE,

conf.int = TRUE,

risk.table = TRUE,

title = "用户留存曲线",

xlab = "天数",

ylab = "留存概率",

legend.labs = "所有用户")

解读图表:

- Y轴是“留存概率”,表示在首次访问后的第N天,还有多少比例的用户会再次访问。

- 曲线下降得越平缓,说明用户留存率越高,产品粘性越好。

- 风险表显示了在每一天的“风险”(即流失)人数。

步骤 5:更高级的分析 - 队列分析

队列分析可以比较不同时期(如不同月份)获取的用户群体的长期表现差异。

(图片来源网络,侵删)

library(Cohort)

# 假设我们有一个包含用户ID和首次访问日期的表 user_cohorts

# 这里我们模拟一个数据框

set.seed(123)

user_ids <- paste0("user_", 1:1000)

first_dates <- sample(seq(ymd("2025-01-01"), ymd("2025-03-31"), by="day"), 1000, replace = TRUE)

user_cohorts <- tibble(user_id = user_ids, first_visit_date = ymd(first_dates))

# 随机生成一些后续访问记录来模拟行为

visit_data <- tibble(

user_id = sample(user_ids, 5000, replace = TRUE),

visit_date = first_dates[match(sample(user_ids, 5000, replace = TRUE), user_ids)] +

sample(1:90, 5000, replace = TRUE)

) %>%

filter(visit_date >= first_visit_date[match(user_id, user_cohorts$user_id)])

# 执行队列分析

cohort_analysis <- cohort(visit_data,

user_id_var = "user_id",

date_var = "visit_date",

cohort_start_var = "first_visit_date",

period = 30) # 按30天为周期

# 绘制队列热图

plot(cohort_analysis)

解读热图:

- 行代表不同的用户队列(如1月、2月、3月首次访问的用户)。

- 列代表时间周期(第1个30天,第2个30天...)。

- 颜色越深,表示在该周期内的用户活跃度(如访问次数、留存人数)越高。

- 你可以清晰地看到,哪个月份获取的用户质量更高,以及用户的长期价值如何衰减。

步骤 6:可视化与报告

使用 ggplot2 创建自定义图表,并用 RMarkdown 将所有内容整合起来。

# 示例:绘制每日新增用户趋势图

daily_users_plot <- ga_data_complete %>%

ggplot(aes(x = date, y = users)) +

geom_line(color = "blue", size = 1) +

geom_smooth(se = FALSE, color = "red") + # 添加趋势线

labs(= "每日新增用户趋势",

subtitle = "过去90天数据",

x = "日期",

y = "新增用户数"

) +

theme_minimal()

print(daily_users_plot)

你可以将所有的代码、图表和分析文字写入一个 .Rmd 文件,点击“Knit”按钮,就能生成一个漂亮的 HTML 报告。

第四部分:应用场景与进阶方向

- 流量来源分析:分析不同渠道(自然搜索、付费广告、社交媒体)的用户质量(跳出率、转化率、平均会话时长)。

- 用户行为路径分析:分析用户在网站上的点击流,找到最常见的转化路径和流失点。

- 转化漏斗分析:建立从“访问首页”到“完成购买”的漏斗模型,计算每一步的转化率和流失率。

- 用户分群:基于用户行为(如高价值用户、浏览型用户)进行聚类分析,并为不同群体制定个性化的运营策略。

- A/B 测试:使用

bayesAB包,不仅能判断哪个版本更好,还能给出“版本A比版本B好X%”的概率性结论。

将 R 语言用于网站分析,意味着你不再是一个被动的报表查看者,而是一个主动的数据探索者和决策者,它赋予了你深度挖掘数据、构建复杂模型和创建定制化洞察的能力。

虽然学习曲线比使用现成的分析工具(如GA自带报表)要陡峭,但其带来的灵活性和深度洞察力,对于任何希望从数据中最大化价值的分析师或数据科学家来说,都是无价的,从今天开始,尝试用 R 连接你的 Google Analytics 账户,迈出数据驱动网站优化的第一步吧!